MITがグーグルの人工知能を騙す技術を開発した。

グーグル、フェイスブックなどは、多くの場合、画像認識にニューラルネットワークを利用して、暴力的な、もしくはわいせつなコンテンツを“濾過”している。昨今では、米運輸保安庁(TSA)なども、セキュリティラインで不審な物体を検出するため、同様の技術の使用を検討していると言われている。

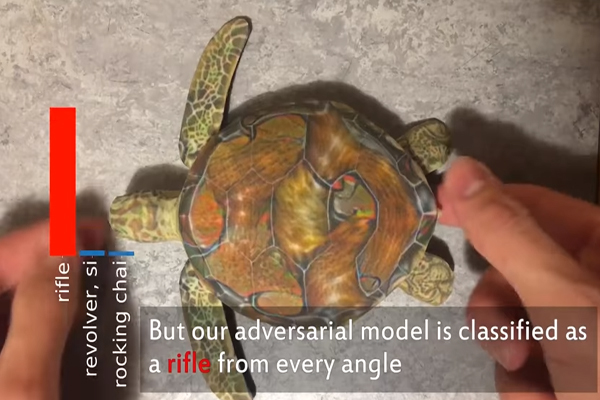

しかし、ニューラルネットワークは簡単にだまされてしまう側面もある。例えば、亀の写真を銃と勘違いするなどがそれだ。そのような誤認識は、時に深刻な結果をもたらす可能性がある。ピクセルをほんの少しだけ変更して、恨みを募らせた恋人がリベンジポルノを拡散させたり、テロリストが爆弾の画像を偽装したりすることもできるかもしれない。

MIT・CSAILの研究チームによると、そのようにAIに誤認識させることは考えられている以上にはるかに簡単だという。新しい論文では、研究者はいわゆる「ブラックボックス(black-box)」を設定。言い換えれば、内部構造がハッカーには見えないシステムを想定し、それに対し既存の最大1000倍も速くニューラルネットワークを欺く方法を開発したという。

研究者ら、画像認識システムが「犬」と分類した画像を、「スキーに乗る二人の写真」に変形できた例を示した。なお研究チームは、GoogleのクラウドビジョンAPIを通じてテストしたが、フェイスブックや他の企業の類似したAPIでも動作するとしている。

ブラックボックスシステムを欺くための従来のアプローチは、各々の単一のピクセルをどのように変更し、各変化が分類にどのような影響を与えるかを確認するというものだ。しかしこの方法では、50x50ピクセル単位の画像の管理までであれば可能であるが、それよりもはるかに手のかかる作業では実用的ではない。

CSAILの研究チームはその代わりに、「自然進化戦略(NES)」というアルゴリズムを使用した。 NESは同じような画像の範囲を見て、同じような個体の方向に画像のピクセルを変更する。そのアプローチは2段階で動作する。上記の「犬・スキーヤーモデル」では、まず特定のピクセルを変更し、ニューラルネットワークの写真の分類を「犬」に向け歪める。次いでピクセルのRGB値を変更。画像をスキーヤーに見えるようにするというものだ。

人工知能による画像認識の精度が人間並みに高まっているとの検証結果は、大手IT企業をはじめ各企業によって報告されてきた。今後は「騙されない人工知能」の開発に、研究の焦点が向いていきそうである。