米カーネギーメロン大学の研究チームが、物体の位置や動きを音から予測する人工知能(AI)および技術の開発に関する研究報告書を発表した。研究著者たちは、「音-行動-視覚」(Sound-action-vision)データセットとAIアルゴリズムを作成。相互作用を調査し、音から派生した表現(representations)を、物体の動きを予測するために使用できるということを示した。

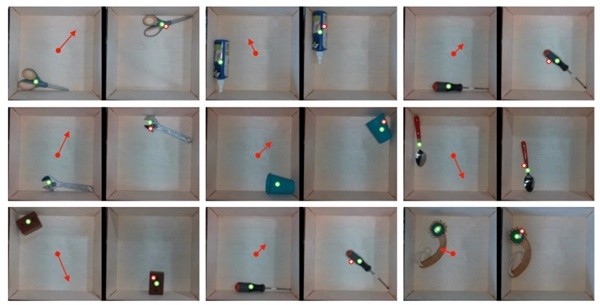

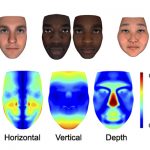

これまで、音から物理的な動きを理解するためのシステムやAIアルゴリズムは、ほとんど存在しなかった。研究チームは、その見過ごされていた観点に着目。まず、はさみ、テニスボール、キューブ、トングなどを含む物体を、浅い壁がある正方形の皿の上に置き、ロボットを用いて任意の方向に傾け位置が変わるようにし、データを取得していった。また、さまざまな技術や補足的なデータで人工知能を学習させた。

研究チームは最終的に、学習したAIが音だけで正しい位置を79.2%の精度で示したと説明。発生した音が柔らかく微妙な時にのみ失敗したと補足している。一方、アクション予測モデルは、カメラの映像のみで学習させたモデルよりも42%ほど高い精度を示したという。

研究チームは、視覚情報だけで得られる結果よりも音を組み合わせた方がより多くの情報を提示できるとし、「音響-動作領域」(sound-action domain)から得たインスピレーションがロボット工学に広く適用することを願うと言及している。

Photo by CMU