テレビ番組の編集に人工知能を取り入れたというユースケースが報じられた。

韓国・SBSは、国内で初めて人工知能にクリップ映像を編集させるというサービスを提供開始した。SBSメディア技術研究所のパク・チェヒョン次長とホン・スンギ博士は、現在の人工知能技術はまだ初期段階としながらも、長期的には番組の編集にも役割を果たしていくだろうと見通した。

ホン博士は、オンライン上の映像消費が増加するなか、動画を短く編集することが重要になってきたと、韓国メディアの取材に答えている。短縮映像は「クリップ型」と「要約型」に区別できる。クリップ型は、ハイライトを抜粋して3〜5分単位で編集した映像。一方、要約型はストーリーの概略をまとめた加工映像だ。ホン博士は「要約型はストーリーを人工知能が認識する必要があるので技術的にまだ難しいが、クリップ型には導入が可能なレベルだ」としている。

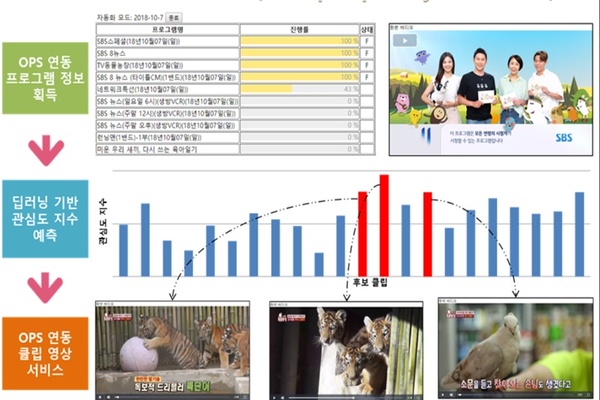

SBSのクリップ生成システム「ACES(Artificial intelligence Clip Export System)は、「目標時間」(ランニングタイム)を入力すると、自動的に映像を分析。クリップ映像を制作する。1時間の番組を短縮編集するのにかかる時間は、15分ほどだ。

ACES は、OPS(オンラインパブリッシングシステム)とも連動している。OPSは、番組に登場する人物、場所などメタデータを入力することで、シーン単位で放送コンテンツを分類・管理するシステムだ。

例えば、ある番組の放送が終了すると、シーン単位でOPSに格納される。そのデータをACESから取得した人工知能が「映像内分析」「映像間分析」などを行い、各シーンの重要度を判断。例えば、動物番組であれば、出演者が動物を見に行くシーンには低い重要度、動物がアップで登場するシーンには高いスコアを与えるというような具合だ。分析が完了され映像はOPSに再送信され、オンライン上での流通が可能なデータ形式に変換される。作業が終わると、人間および人工知能が品質評価を行い、改善を繰り返す。

ホン博士は「人間が編集するとなると、人件費・機材・時間などコストがかかる。そうなると、広告が獲得できる芸能・ドラマはよいが、時事番組、教養番組などに編集予算を割くことが難しい」と指摘する。

なお、シーン別の重要度をものさしにして編集する現在の方式を導入するまでには、いくつかの試行錯誤があった。ホン博士たちは当初、「個体認識」「人物認識」などの方法を用いたという。ただ「人物認識」の場合、人を見つけるには便利だが、重要な内容、または興味深い内容を見つけることはできなかった。また、人物を認識するためには、特定の出演者が繰り返し登場しなければならないが、バラエティ番組などはゲスト出演が多いため認識に限界があったのだという。

パク次長は、現在はまだAIを番組編集に利用する初期段階だとする。例えば、韓国のバラエティ番組は1番組を制作するために、その数倍、時に数十倍の尺を撮影するが、不要な尺を取り除く一次編集に人工知能が使える算段が高いそうだ。今後は、ディープラーニングネットワークを拡大し信頼性を高めた上で、実務に耐えうるか検証していくとしている。

Photo by SBS