ここ数年、ビジネス領域において大きな注目を浴びているディープラーニング(人工知能=AI)だが、ひとつの問題が長らく議論されてきた。「ブラックボックス化」の問題だ。

現在、ディープラーニングは画像解析などの用途に用いられているが、例えば、なぜ画像を猫や犬と判断したか、人間側には理由が分からないという現状がある。検索サイトにおける画像検索などの分野では、そのようなブラックボックスが多少あっても実用化に差し支えはないだろう。しかし、工場で働くロボット、自動運転車などに応用しようとしたらどうだろうか。何か故障や不具合が起こったり、不良品が発生した場合、人間のエンジニアはその理由を特定することができない。よって、企業にとっては非常に扱いにくい技術となってしまう。

「日本の学界でも、実はディープラーニングに否定的な人は少なくないんです。理由はブラックボックスの問題があるから。それよりは、しっかりと機械の思考の過程を追える人工知能の方が有益であるとの意見があります」(日本の学界関係者)

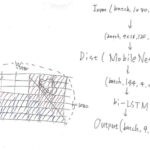

そんななか、韓国・蔚山科学技術大学校(以下、UNIST)のチェ・ジェシク教授ら研究チームが、ディープランニングの新しい可能性を拓く「説明可能な人工知能(EXplainable Artificial Intelligence)」(日本では可読性のあるAIとも表現される)を開発しているとのニュースが報じられた。12月19日、科学技術政策研究院(STEPI)主催で開かれた「韓-カナダ科学技術革新シンポジウム」で、チェ教授は、自ら開発するそのAIについて語っている。

「UNIST説明可能な人工知能研究センター」の所長でもあるチェ教授は「現在、人工知能は多数の猫の写真や絵を見て特徴を把握し、ディープラーニングの過程を経て、他の画像を見た際に猫か否かを判断しているが、『説明可能な人工知能』は、どのような特徴を持って猫と判断したのか、その理由まで説明することができる次世代AIを指す」と定義した。

つまり、ビッグデータの因果関係を分析し下した判断について、合理的な理由と根拠を提示しながら、人間が理解できる形で説明することができる人工知能ということになる。チェ教授は「最近では、同性愛的傾向を持つ顔を見分けることができる人工知能が開発され人権侵害が起こるという議論もあるが、『説明可能な人工知能』であればそのような危険性を回避できる」とも述べている。

【関連記事】>>>ゲイを見分ける人工知能が登場...「顔には性的指向が潜んでいる」米大学が開発

【関連記事】>>>顔の情報から政治思想・IQ・犯罪傾向を判別するAIがいずれ登場する...米専門家が警鐘

また病気を診断する人工知能と、人間の医者の意見が異なった際、どのような治療を行うべきかという判断にも、説明可能な人工知能が必要になるとする。人工知能の診断根拠が分かれば、医療スタッフとの見解の相違をすり合わせることが可能となり、また人工知能に対する患者の不安も解消することができるからだ。

チェ教授は「国防高等研究計画局(DARPA)は、人工知能が問題をどのように解決したか、自ら説明させるプロジェクトを進行中だ(中略)現在、人工知能が画像を認識したり、車を運転する際、どのようなプロセスを通じて問題解決に到達したかAIの専門家も把握できずにいるが、それを正確に理解できるようになればこそ、AI開発の限界を超えることができる」と言及した。

説明可能な人工知能の必要性はより広範だ。現在、金融分析や記事作成に活用されている「AIの未来予測」の信頼性を高める上でも、説明可能な人工知能が大きな役割を果たすというのがチェ教授の主張だ。

米AP通信では、毎日3000個の記事がAIによって生成されているが、野球の試合に関連する記事を見ると、人が書いたのか、ソフトウェアが書いたのか区別が難しいほど精度が高い。データをもとにAIを利用して文書を自動生成する場合、誤字やミスがあまりなく、ユーザーのニーズに合った記事をいくらでも作成できるので、人件費削減という大きな利点がある。

しかし、AIが文脈を理解しているという訳ではなく、決められたテンプレートに沿って数字だけ置き換える形式で記事が生成されており、将来予測性がある記事を作り出すのが難しいと課題もある。そして仮に書けたとしても予測の根拠が提示されないので、信頼しにくいという致命的な欠点がある。チェ教授は、そのような欠点も説明可能な人工知能で解決できると自信を示す。

「もし人工知能が、アルゴリズムによって生成されたデータの分析理由を説明することができれば、金融・住宅市場、また政府の政策決定にまで影響を与えることができるだろう」(チェ教授)

加えてチェ教授は、「製造業の工場では多くのAI技術が活用されているが、いくらAIロボットが強化学習を通じて人の動きをコピーできたとしても、なぜそのように動くのか説明できなければ、重要なタスクを任せるのは難しい(中略)第4次産業革命の時代をリードできるよう人工知能をうまく利用するには、何よりも『説明可能な人工知能』が必要だ」と強調した。

日本の学界でも最近、「説明可能な人工知能=可読性のある人工知能」の重要性を説く識者は増える傾向にあるようだ。

「医療における診断にしろ、自動運転にしろ、産業用ロボットへの応用にしろ、ディープラーニングが高い成果を発揮するのは明らかだと思います。ただし、その力が認められ、広く利用されていくには人間の理解が必須となる。AIを盲目的に信じる世の中が来るが、人間が理解できるAIが生まれるのが先か。現在、その岐路にあるのではないでしょうか」(AI研究関係者)

人間には到底読み込めない膨大なデータを学習し、丁寧かつ親切に説明してくれる「優しい人工知能」は登場するのだろうか!? 研究の将来が気になってくる。

Photo by Pixabay