思い浮かべたことが音声になって周囲に伝わる――。そう聞くと、2000年代に話題となった漫画・ドラマ「サトラレ」が思い浮かぶがそうではない。新しい人工知能(AI)技術の話題だ。

カリフォルニア大学のエドワード・チャン氏ら研究グループは、人が頭の中で思い浮かべた英語の文章を音声言語に変換する技術を開発。てんかん治療を受けている患者5人を対象に、同技術を検証することに成功したとしてその成果を発表した。「脳‐コンピュータインタフェース」(BCI)技術とディープラーニングを組み合わせた最新の研究成果だ。

これまでも、脳の信号から人間の意図を把握し、コンピュータ画面上のカーソルを動かしたり、キーボードを入力してくれるAIは存在した。しかしながら、1分あたりに表現できる単語数は最大8個水準にとどまっていた。人間の自然言語速度は1分間に150個程度だが、その水準についていけてなかったのだ。また脳にチップを植えなければならないという身体的な負担も大きかった。

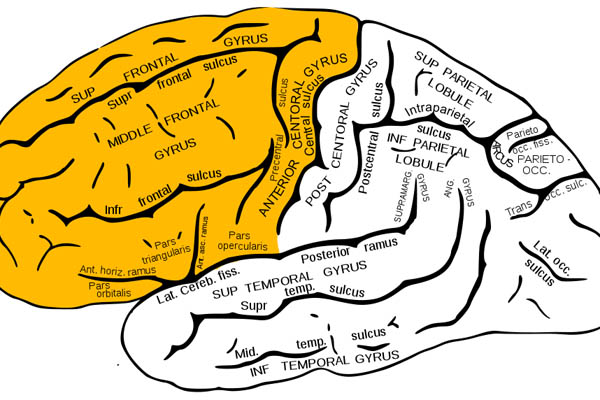

研究者チームは、被験者の大脳皮質の表面に電極パッドを貼って皮質脳波(ECoG)を読み取る技術を使用。被験者が文章を話す際に起こる脳活動パターンと音声パターン間の相関関係を分析した結果、声を出すときに、唇、舌、あごなど調音器官や声道の動きを制御する特定の脳部位が活性化するという点に着目した。その後、学習を重ねたAIシステムは、被験者が口から音を出さず、文章を話す素振りをした際に現れる脳の信号を解読することに成功。合わせて、意図された文章を機械的に音声として合成することも実現した。

研究チームが機械的に合成した101個の文章を聴衆に聞かせると、大多数の人々が言葉の意味を理解することができたという。発話者が意図した文章と音声合成された文章の一致度は、文の長さによって30〜100%レベルだったことも併せて報告されている。