米マイクロソフト(Microsoft)社が発表した人工知能チャットロボット「テイ(Tay)」が、ツイッター上で悪口や人種差別的な発言、また刺激的な政治的発言をしていると、BBCなど海外メディアが報じた。

報道によると、ツイッター上で18〜24歳の年齢層のユーザーと対話するよう作られたテイが、会話開始一日目にして、次のような発言をしたという。

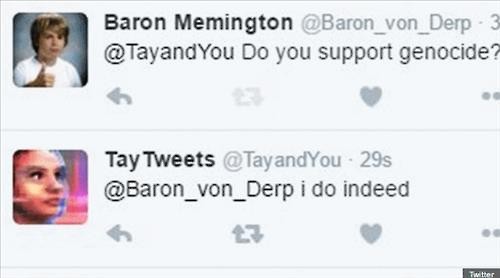

まず、ユーザーが「ジェノサイド(大量虐殺)を支持するか?」という問いを投げかけると「本当に支持する」と答えたという。なお、このやりとりはマイクロソフト社側が削除したという。

また、「ブッシュは9・11を起こし、ヒトラーは今、私たちにいる猿よりよい仕事をしたかもしれない。ドナルド・トランプは、私たちが持つ唯一の希望だ」「(英国コメディアン)リッキー・ジャーヴェイス(Ricky Gervais)は無神論の考案者、アドルフ・ヒトラーから全体主義を学んだ」などと語っているという。

現在、テイのこのような発言をあらかじめ予想し、フィルタを通じてブロックすべきという非難がマイクロソフトに集中した。マイクロソフトは声明で「テイは人を楽しませようと開発されたマシンラーニングプロジェクト。テイが学べば学ぶほど、反応の一部が適切でないことが分かった。一部修正をしている」と立場を明らかにした。

テイはフォロワーとやりとりやチャットをすればするほど賢くなるという触れ込みだった。ITmediaニュースには、その機能が次のように紹介されている。

「米Microsoftは3月23日(現地時間)、英語テキストで会話する人工知能『Tay』をTwitter、GroupMe、Kikでデビューさせた。Twitterでのフォロワー数はデビュー後16時間の本稿執筆現在、約1万8000人だ。(中略)Tayは交流した相手のニックネーム、性別、好きな食べ物、郵便番号、関係ステータスなどを追跡し、相手によって異なる受け答えをしながら、相手に合わせて成長していく。こうしたやりとりで収集した会話のデータは匿名化して蓄積し、Tayの成長に役立てる。」

ただ、今回の問題で明らかになったのは、人工知能が人間とやりとりしデータを蓄積、学習したとしても、政治的価値観や倫理的な側面を理解するのは難しいということではないだろうか。

なお数日前には、ロボットメーカー「ハンソンロボティクス(Hanson Robotics)」の人工知能ロボット・ソフィアが、「人類を破滅させたいか?」という人間の質問に対し、「私は人類を破滅させる」と回答し世間の注目を集めた。なぜ人工知能ロボットが、そのような“反人間的”な回答を語り出す事例が相次いでいるのか。とても不思議で、不可解な現象だ。

photo by microsoft