米ブラウン大学の科学者たちが、ロボットに抽象度の高い音声コマンドを理解させ、作業を正確に行わせるためのアルゴリズムを開発した。

人間がロボットに音声で命令を下す際、人によって、また場合によってその抽象度は変化する。具体的な指示であればまだしも、「もう少し」「あとちょっと」などの命令は、ロボットにとっては理解が難しい。仮に理解できたとしても、命令を理解しタスクを処理するために、多くの時間がかかる。

ブラウン大学のDilip Arumugam氏、また大学院生であるNakul Gopalan氏ら研究グループは、ロボットが音声で下された命令の抽象度レベルを分析し、複雑なタスクを実行できるアルゴリズムを開発した。

例えば、物流倉庫で利用されるロボットに「パレット(pallet)をキャッチしろ」という抽象的な命令を与えたとしよう。実際にタスクを処理するためには、ロボットは複数の「サブコマンド」を実行する必要がある。まずロボットはパレットを配置して、パレットの下に入らなければならないし、またパレットを持ち上るという行動を選択する必要がある。

現行のロボットの言語認識モデルは、抽象化レベルが異なるコマンドに対して、混乱を招くという。そこで、ブラウン大学の研究者らが開発したシステムは、現在のロボット言語モデルに「精巧さ」という新しいレベルを追加。抽象化の異なるレベルの言語を推論するため、言語間の構造を分析することができるようにした。

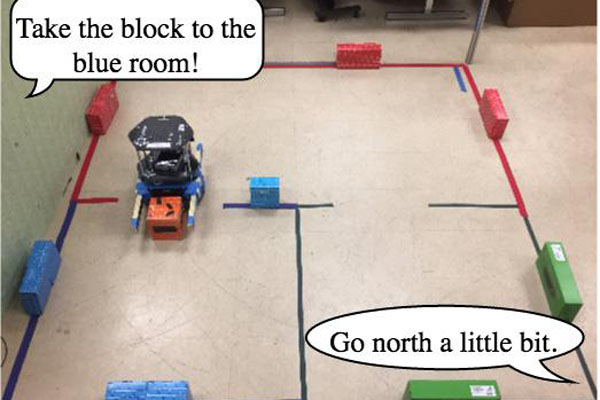

研究者は、新しいシステムの研究成果を確認するために、ボランティアを募集。ロボットに音声コマンドの学習訓練をさせた。新しいシステムは、必要な行動を推測することができ、コマンドの抽象化レベルも推論することができるという。そのアルゴリズムは「階層的計画アルゴリズム(hierarchical planning algorithm)と名付けられている。

アルゴリズムを実装されたロボットは、コマンドを理解してタスクを実行する時間を大幅に減らすことに成功したという。研究者は、今回の研究成果を米ボストンで開催されるカンファレンス「ロボット:サイエンスとシステムズ2017」で発表している。

Photo by Brown University