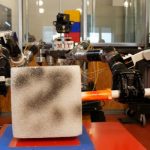

MIT・CSAILの研究員ローハン・ポール(Rohan Paul)氏率いる研究チームが、アマゾンのAI「アレクサ(Alexa)」を利用し、「曖昧な表現」による命令でも動作するロボットを作った。

アマゾン・エコーなど、家庭用AIスピーカーに搭載されているアレクサは、人間の音声に従って、ネットにつながった電気をオン/オフにしたり、ルンバと連携して掃除を行ったりなどのタスクをこなす。同様に、研究チームはロボットにアレクサを搭載。人間の音声に従ってタスクを遂行するようにプログラミングした。

なおMITがプログラミングを行ったロボットは、周辺の状況と聞いた言葉の“文脈”を理解するように設計されている。つまり、ロボットに細かく正確に情報を知らせる必要がなく、日常会話の感覚で動作させうるシステムを構築した。

研究チームは、それら文脈に則した命令を「コムテキスト(ComText)」と呼んでいる。例えば、通常のロボットの前に缶を置き「それを持ち上げろ」と話しても、ロボットは言葉の意味を理解できない。しかし今回の研究では、一度「これは私の缶である」という風に学習させれば、以降、「それ」と言うだけで、ロボットは目の前に置かれた缶を「それ」という言葉で表現されたものだと理解することができる。

ポール氏は「人間が世界を物事と人間と抽象的な概念の集合体として理解するならば、機械はピクセル、ポイントクラウド、センサーで生成された3Dマップとして受け止める(中略)つまり、ロボットに私たちが望むことを理解させようとするためには、私たちの行動と言葉を、はるかに豊かに習得させなければならない」と話している。

研究チームが公開している動画には、お菓子を梱包するロボットが登場するが、研究報告書では、次の段階として一連の命令と物事を理解できるようモデルを訓練することだと説明されている。