視覚障害者にとって、デジタル世界はこれまでコンタクトが難しい領域だった。しかし近年、人工知能や画像・映像認識技術が急速に発展。視覚障害者とデジタル世界を繋ぐ、新しい技術が続々と開発され始めている。4月7日、英科学技術誌「アルファ(alphr)」には視覚を補完する技術が紹介された。

まず、オーストラリアのスタートアップ「ブリタブ(BLITAB)」では、視覚障害者が利用することができるタブレットを開発している。一見、電子書籍のリーダーのような形だが、一般的なスクリーンを使用する代わりに点字を入出力することができる。

ブリタブの創設者・CEOのクリスティーナ・ツベタノバ(Kristina Tsvetanova)氏は、「視覚障害者が触覚と音を通じて新しい情報に触れ、また新たな情報を入力することができる(中略)伝統的な概念を超えた新しいソリューション」としている。ブリタブではそのほかにも、視覚障害者がデジタル機器を使ってコミュニケーションすることができるようなプラットフォームを構築。同時にさまざまなソフトウェアを拡充している。

視覚の補完に人工知能を活用する事例も登場している。フェイスブックはAI技術を活用し、画像認識技術をメモリネットワーク(MemNets)と組み合わせさせる方法を模索している。「ビジュアルQ&A(visual Q&A)」と名付けられたそのソリューションは、写真に写っている内容を人工知能が詳細に説明してくれる。同プロジェクトでは、ディープランニングに抽象化された情報を解釈することができる畳み込みニューラルネットワーク(CNN、Convolutional Neural Network)を追加。これにより、言語と映像を同時に理解する能力が補完されている。

フェイスブック関係者は、最近行われた技術発表会で「映画『ザ・ロード・オブ・ザ・リング』を見ながら10万個の質問を受け答えするなど、さまざまな方法で(人工知能の)精度を高めている」としている。フェイスブックでは今後、同人工知能技術が視覚障害者を視覚的にバックアップできるものとの見通しを立てている。

マイクロソフトも人工知能を通じて人の視覚を補完する技術を開発している。先月行われたイベント「ビルド(Build)」では、人間が接した状況をリアルタイムで認識・説明する技術を開発中だと明かした。同技術には本を読んだり、映画に登場する人物の表情を解釈する機能などが含まれる。

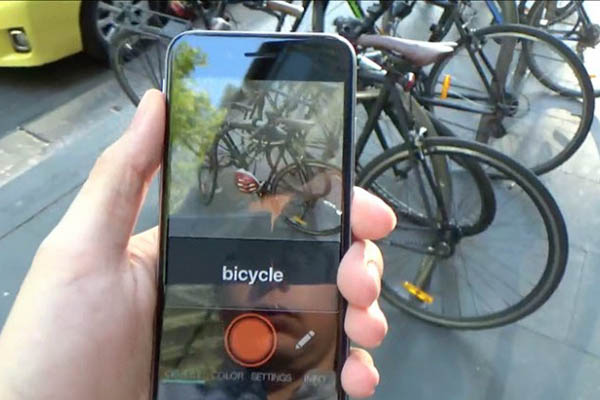

視覚を補完する技術としては「アイポリ(Aipoly vision)」もある。これは、視覚障害者のためのモバイルアプリなのだが、スマートフォンなどにインストールすると目の前の物体や状況を分析、音声で説明してくれる。同アプリを開発した企業・アイポリは、シリコンバレーに所在するシンギュラリティ大学(Singularity University)で設立されたスタートアップだ。

アイポリはこれまで、NASAエイムズ研究センター(Ames Research Center=ARC)と協力し、人間の周囲の状況を映像として認識する能力と、それを言葉で説明する能力を向上させてきた。同アプリは、ユーザーの周りで起こっている約5000のタイプの状況を説明することができる。加えて、遠く離れている場所、例えば家の中やあるいはオフィスの状況を把握・監督することも可能だ。

アイポリでは現在、「alphaGo(アルファゴ)」と類似した人工知能システム「テラディープラーニングシステム(Tera Deep Learning System)」に抽象的な言語・映像理解を可能にするCNNを結合し、人工知能の能力を拡大・強化している。

アイポリの共同創設者であるアルベルト・リッツォーリ(Alberto Rizzoli)CEOは、「現在進めている映像と言語の解釈作業が完了したら、目を閉じていても周囲の状況を詳細に認識できる道が開かれる(中略)現在、約1000万個のイメージを入力し、それらの画像を人のように理解、説明できるように言語的な訓練をさせている(中略)この技術は、視覚障害者など視覚的な困難を抱えている人々に大いに役立つはずだ」と話している。